OpenAI, Google et Anthropic se heurtent à des obstacles dans l’avancement des modèles d’IA, ce qui laisse planer des doutes sur l’AGI à court terme

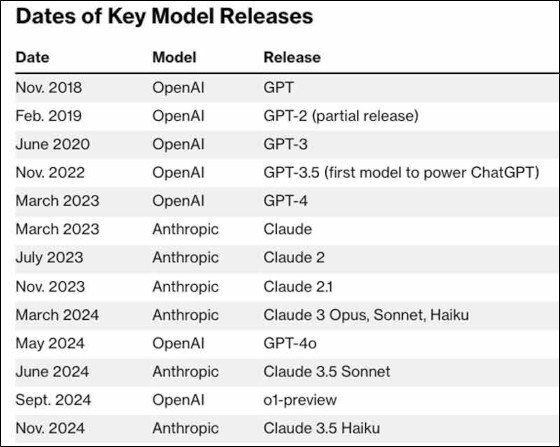

Les entreprises technologiques qui se concentrent sur le développement de chatbots, comme OpenAI, Google et Anthropic, ont été confrontées à d’importants vents contraires à court terme pour faire progresser les grands modèles de langage. Malgré des dizaines de milliards de dollars d’investissements, ces entreprises technologiques enregistrent des rendements décroissants dans la mise au point de LLM plus sophistiqués.

Des sources ont indiqué à Bloomberg que le nouveau LLM Orion d’OpenAI a connu des limitations de performance. Cela signifie que le nouveau LLM serait plus performant que les modèles existants de l’entreprise, mais cela ne signifie pas qu’il y aura un saut significatif dans le développement, comme celui de GPT-3 à GPT-4.

« À la fin de l’été, par exemple, Orion n’était pas à la hauteur lorsqu’il tentait de répondre à des questions de codage pour lesquelles il n’avait pas été formé, ont déclaré les personnes concernées. Dans l’ensemble, Orion n’est pas considéré jusqu’à présent comme un progrès aussi important par rapport aux modèles existants d’OpenAI que GPT-4 l’était par rapport à GPT-3.5, le système qui alimentait à l’origine le chatbot phare de l’entreprise, ont déclaré les personnes. » – Bloomberg

Le rythme effréné du développement de LLM plus sophistiqués semble également avoir frappé un mur proverbial chez Google, où son logiciel Gemini n’a pas répondu aux attentes, selon les sources, ajoutant qu’Anthropic est également confronté à des défis avec son modèle Claude tant attendu, appelé 3.5 Opus.

Bloomberg note que l’un des principaux obstacles rencontrés par ces entreprises technologiques a été de « trouver de nouvelles sources inexploitées de données d’entraînement de haute qualité, créées par l’homme, qui peuvent être utilisées pour construire des systèmes d’IA plus avancés ».

Selon certaines sources, les piètres performances d’Orion en matière de codage s’expliquent par le manque de données de codage suffisantes pour entraîner le LLElles ont ajouté que même si le modèle présente des améliorations par rapport aux anciens modèles, il est de plus en plus difficile de justifier les coûts considérables liés à la construction et à l’exploitation de nouveaux modèles.

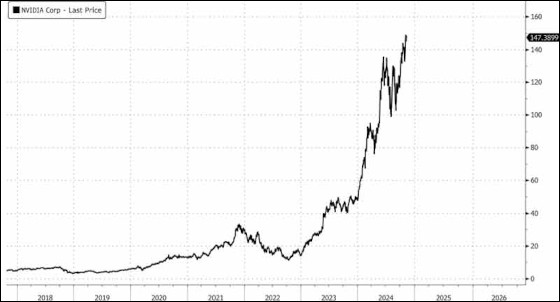

Ces revers pourraient révéler une vérité dérangeante pour l’industrie technologique qui consacre des dizaines de milliards de dollars aux centres de données et à l’infrastructure de l’IA, et la possibilité d’atteindre l’intelligence générale artificielle dans un avenir proche pourrait être une chimère.

John Schulman, cofondateur et chercheur scientifique d’OpenAI, qui a récemment quitté l’entreprise, a déclaré que l’AGI pourrait être atteinte dans quelques années. Dario Amodei, PDG d’Anthropic, pense qu’elle pourrait voir le jour d’ici 2026.

Cependant, Margaret Mitchell, responsable de l’éthique chez Hugging Face, une startup spécialisée dans l’IA, a fait remarquer que « la bulle de l’AGI est en train d’éclater un peu », ajoutant que des « approches de formation différentes » pourraient s’avérer nécessaires pour progresser.

Dans un entretien récent avec Lex Fridman, Amodei, d’Anthropic, a déclaré qu’il y a « beaucoup de choses » qui pourraient « faire dérailler » la progression de l’IA, y compris la possibilité que « nous manquions de données ». Il s’est toutefois montré optimiste quant à la capacité des chercheurs en IA à surmonter les obstacles.

Les efforts de mise à l’échelle ralentissent….…

« Il s’agit moins d’une question de quantité que de qualité et de diversité des données », a déclaré Lila Tretikov, responsable de la stratégie en matière d’IA chez New Enterprise Associates et ancienne directrice adjointe de la technologie chez Microsoft.

Selon elle, « nous pouvons générer des quantités de manière synthétique, mais nous avons du mal à obtenir des ensembles de données uniques et de haute qualité sans l’aide de l’homme, en particulier lorsqu’il s’agit du langage ».

Noah Giansiracusa, professeur agrégé de mathématiques à l’université Bentley de Waltham (Massachusetts), estime que les modèles d’IA continueront à s’améliorer, mais que l’hypercroissance de ces dernières années n’est pas viable :

« Nous avons été très enthousiastes pendant une brève période de progrès très rapides. Ce n’était tout simplement pas durable. »

Si les entreprises technologiques peinent à améliorer les performances du LLM, cela soulève de sérieux doutes quant à la possibilité de continuer à investir massivement dans l’infrastructure de l’IA.

« La construction de l’infrastructure pour l’IA est la bulle. Les entreprises d’IA 2.0 capables de trouver un moyen de la monétiser seront celles qui investiront dans les années à venir. Autant allumer une allumette pour ce fonds. La construction de l’infrastructure, comme l’infrastructure des télécommunications pendant le boom de l’Internet, sera surabondante et les prix s’effondreront », a récemment déclaré Edward Dowd sur X.

Le fait que les entreprises spécialisées dans l’IA s’efforcent de mettre au point des modules de formation continue plus avancés est sans aucun doute un signe inquiétant pour la bulle de l’IA.

yogaesoteric

29 novembre 2024