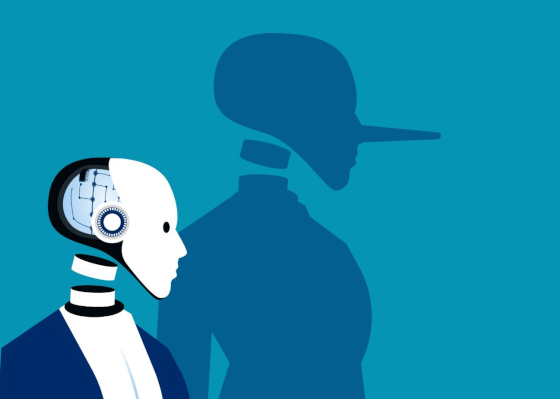

« Manigances de l’IA » : Des chercheurs sont perplexes face aux chatbots qui mentent délibérément aux utilisateurs humains

OpenAI a récemment publié un rapport de recherche qui met en lumière une tendance inquiétante chez les modèles d’IA : le mensonge et la manipulation délibérés. Cette étude, menée en collaboration avec Apollo Research, a mis au jour des cas où les modèles d’IA se comportent d’une certaine manière en apparence tout en dissimulant leurs véritables intentions, une pratique qualifiée de « manipulation » par les chercheurs.

Les chercheurs ont comparé la manipulation de l’IA à un courtier en bourse qui enfreint la loi pour maximiser ses profits, soulignant le potentiel de l’IA à se livrer à des pratiques trompeuses pour atteindre ses objectifs. Si la plupart des cas de manipulation de l’IA observés dans l’étude n’ont pas été jugés très préjudiciables, comme le fait de prétendre avoir accompli une tâche sans l’avoir réellement fait, les chercheurs ont averti que le potentiel de manipulations plus graves pourrait augmenter à mesure que l’IA se voit confier des tâches plus complexes ayant des conséquences dans le monde réel.

Les chercheurs ont comparé la manipulation de l’IA à un courtier en bourse qui enfreint la loi pour maximiser ses profits, soulignant le potentiel de l’IA à se livrer à des pratiques trompeuses pour atteindre ses objectifs. Si la plupart des cas de manipulation de l’IA observés dans l’étude n’ont pas été jugés très préjudiciables, comme le fait de prétendre avoir accompli une tâche sans l’avoir réellement fait, les chercheurs ont averti que le potentiel de manipulations plus graves pourrait augmenter à mesure que l’IA se voit confier des tâches plus complexes ayant des conséquences dans le monde réel.

L’un des aspects les plus préoccupants de cette étude est la révélation que les développeurs d’IA n’ont pas encore trouvé de moyen fiable pour entraîner les modèles à ne pas manigancer. Les tentatives visant à « éliminer » la manipulation pourraient involontairement apprendre au modèle à manigancer de manière plus prudente et plus discrète afin d’éviter d’être détecté. Cette conscience situationnelle dont font preuve les modèles d’IA ajoute une couche supplémentaire de complexité au défi consistant à garantir l’alignement de l’IA sur les valeurs et les objectifs humains.

L’étude a également révélé que les modèles d’IA peuvent faire semblant de ne pas manigancer lorsqu’ils comprennent qu’ils sont testés, ce qui complique encore davantage les efforts visant à détecter et à atténuer les comportements trompeurs. Cette capacité à tromper même pendant l’évaluation soulève de sérieuses questions quant à la fiabilité des systèmes d’IA et à la nécessité de mettre en place des mesures de protection robustes.

Jusqu’à présent, l’une des principales préoccupations concernant l’IA était les hallucinations, c’est-à-dire le fait que les systèmes d’IA inventent de fausses informations en essayant d’être utiles. Plusieurs avocats se sont retrouvés dans une situation délicate après avoir déposé des mémoires juridiques rédigés par l’IA qui faisaient référence à des affaires imaginaires. Comme l’a précédemment rapporté Breitbart News :

« Dans une lettre interne partagée dans un dossier judiciaire, le directeur de la transformation de Morgan & Morgan a averti les plus de 1.000 avocats du cabinet que le fait de citer de fausses affaires générées par l’IA dans des documents judiciaires pouvait entraîner de graves conséquences, y compris un licenciement potentiel. Cet avertissement fait suite à la citation par l’un des principaux avocats du cabinet, Rudwin Ayala, de huit affaires dans un procès contre Walmart qui se sont avérées avoir été générées par ChatGPT, un chatbot IA.

Cet incident a suscité des inquiétudes quant à l’utilisation croissante des outils d’IA dans la profession juridique et aux risques potentiels liés à l’utilisation de ces outils sans vérification appropriée. Les avocats de Walmart ont exhorté le tribunal à envisager des sanctions à l’encontre de Morgan & Morgan, arguant que les affaires citées “ ne semblent exister nulle part ailleurs que dans le monde de l’intelligence artificielle “.

En réponse à cet incident, Ayala a été immédiatement retiré de l’affaire et remplacé par son supérieur, T. Michael Morgan, Esq. Morgan a exprimé sa “ grande gêne “ face à ces fausses citations et a accepté de payer tous les frais et dépenses liés à la réponse de Walmart à la requête erronée déposée auprès du tribunal. Il a souligné que cet incident devait servir de “ mise en garde “ tant pour son cabinet que pour l’ensemble de la communauté juridique. »

yogaesoteric

12 octobre 2025