Scientifique de Microsoft : Les IA capables de lire les émotions sont vouées à l’échec

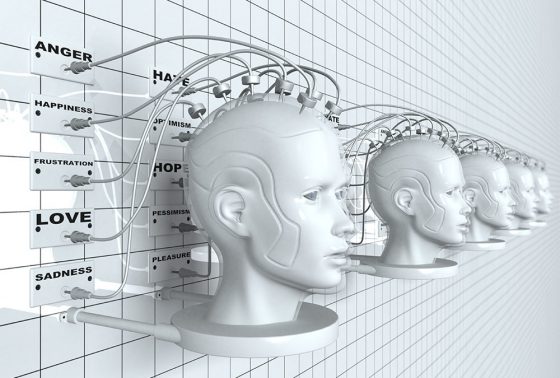

IA affective

Les concepteurs d’intelligence artificielle ont un don étrange pour réinventer les pseudo-sciences de pacotille. Qu’il s’agisse de ressusciter la phrénologie sous la forme d’une reconnaissance faciale censée déterminer la personnalité d’une personne ou de prétendre détecter universellement les émotions sur la base de l’apparence, le domaine de l’IA a depuis longtemps la prétention de réaliser l’impossible.

Le problème est que la construction d’un algorithme capable de détecter les émotions d’une personne ignore les différences culturelles et d’autres facteurs importants, affirme Kate Crawford, chercheuse chez Microsoft et à l’université Annenberg de Californie du Sud, dans The Atlantic. Dans une adaptation de son livre « Atlas of AI : Power, Politics, and the Planetary Costs of Artificial Intelligence », Kate Crawford retrace l’histoire compliquée et imparfaite des scientifiques qui ont tenté de lier les émotions à des mouvements faciaux spécifiques – et explique comment les algorithmes d’IA qui tentent de faire de même sont essentiellement voués à l’échec.

Le problème est que la construction d’un algorithme capable de détecter les émotions d’une personne ignore les différences culturelles et d’autres facteurs importants, affirme Kate Crawford, chercheuse chez Microsoft et à l’université Annenberg de Californie du Sud, dans The Atlantic. Dans une adaptation de son livre « Atlas of AI : Power, Politics, and the Planetary Costs of Artificial Intelligence », Kate Crawford retrace l’histoire compliquée et imparfaite des scientifiques qui ont tenté de lier les émotions à des mouvements faciaux spécifiques – et explique comment les algorithmes d’IA qui tentent de faire de même sont essentiellement voués à l’échec.

Essayer, essayer encore

Les scientifiques essaient depuis des décennies de codifier les expressions faciales liées aux différentes émotions, écrit M. Crawford, mais cela n’a jamais fonctionné. Les chercheurs ont essayé à plusieurs reprises de créer des images idéalisées de personnes exprimant une expression correspondant à une émotion spécifique, mais les correspondances entre les photos qui avaient un sens dans une culture donnée n’en avaient pas dans d’autres, si bien que former un algorithme à faire de même apparaît comme un exercice futile.

Prenons l’exemple de l’algorithme de détection des expressions faciales de l’Administration de la sécurité des transports (Transportation Security Administration), SPOT, qui, selon M. Crawford, était destiné à repérer automatiquement les terroristes après le 11 septembre 2001 en identifiant les voyageurs exprimant du stress, de la peur ou de la déception. Malgré les 900 millions de dollars dépensés pour cet algorithme, rien ne prouve qu’il ait jamais fonctionné.

« C’est le danger de l’automatisation de la reconnaissance des émotions. Ces outils peuvent nous ramener au passé phrénologique, lorsque des allégations fallacieuses étaient utilisées pour soutenir les systèmes de pouvoir existants », a écrit Crawford. « Les émotions sont compliquées, et elles se développent et changent en fonction de nos cultures et de nos histoires – tous les contextes multiples qui vivent en dehors du cadre de l’IA. »

yogaesoteric

8 iunie 2021