Quels sont les plus grands dangers perçus de l’IA ?

Comme chaque avancée technologique, les outils d’intelligence artificielle générative tels que ChatGPT d’OpenAI, le générateur d’images Midjourney ou Claude, le chatbot créé par la startup d’IA Anthropic, sont utilisés à des fins de productivité et de création, mais aussi de plus en plus à des fins d’escroquerie et d’abus.

Parmi cette nouvelle vague de contenus malveillants, les deepfakes sont particulièrement remarquables.

Parmi cette nouvelle vague de contenus malveillants, les deepfakes sont particulièrement remarquables.

Ces contenus audiovisuels générés artificiellement comprennent des escroqueries électorales par le biais de l’usurpation d’identité de politiciens ou la création d’images pornographiques non consensuelles de célébrités.

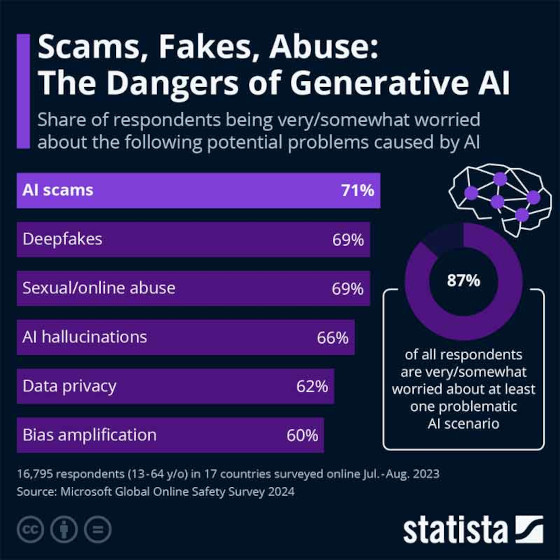

Cependant, comme le rapporte Florian Zandt de Statista, une récente enquête de Microsoft montre que les faux, les escroqueries et les abus sont ce qui inquiète le plus les utilisateurs en ligne dans le monde entier.

71 % des personnes interrogées dans 17 pays par Microsoft en juillet et août 2023 étaient très ou assez inquiètes des escroqueries assistées par l’IA.

Sans préciser davantage ce qui constitue ce type d’escroquerie, il est très probable qu’elle soit liée à l’usurpation de l’identité d’une personne publique, d’un fonctionnaire ou d’une connaissance proche des personnes interrogées.

Sans préciser davantage ce qui constitue ce type d’escroquerie, il est très probable qu’elle soit liée à l’usurpation de l’identité d’une personne publique, d’un fonctionnaire ou d’une connaissance proche des personnes interrogées.

Les deepfakes et les abus sexuels ou en ligne arrivent en deuxième position avec 69 %.

Les hallucinations de l’IA, qui sont définies comme des chatbots tels que ChatGPT présentant des réponses absurdes comme des faits en raison de problèmes liés au matériel de formation, arrivent en quatrième position, tandis que les préoccupations relatives à la confidentialité des données, qui sont liées à de grands modèles de langage formés sur des données publiques d’utilisateurs sans leur consentement explicite, arrivent en cinquième position avec 62 %. Dans l’ensemble, 87 % des personnes interrogées s’inquiètent au moins quelque peu d’un scénario problématique lié à l’intelligence artificielle.

Malgré l’ampleur du marché de l’intelligence artificielle – estimé entre 300 et 550 milliards de dollars en 2024 par diverses sources – les résultats de l’enquête indiquent qu’ignorer ses pièges et ses dangers potentiels pourrait s’avérer préjudiciable à la société dans son ensemble. C’est particulièrement vrai dans des domaines sensibles comme la politique. Avec les élections présidentielles américaines qui se profilent à l’horizon de l’automne, le paysage des médias sociaux est voué à être envahi de fausses informations et de désinformations générées artificiellement.

Lors d’une récente audition sur le thème des deepfakes et de l’IA utilisée dans les cycles électoraux, Ben Colman, PDG de Reality Defender, une entreprise spécialisée dans la détection des deepfakes, a fait l’éloge de certains aspects de l’IA générative, tout en soulignant ses dangers :

« Je ne peux pas m’asseoir ici et énumérer toutes les utilisations malveillantes et dangereuses des deepfakes qui ont été lâchées sur les Américains, ni citer les nombreuses façons dont elles peuvent avoir un impact négatif sur le monde et éroder des facettes majeures de la société et de la démocratie », a déclaré Colman.

« Après tout, je ne dispose que de cinq minutes. Ce que je peux faire, c’est tirer la sonnette d’alarme sur l’impact que les deepfakes peuvent avoir non seulement sur la démocratie, mais aussi sur l’Amérique dans son ensemble ».

Cette nouvelle voie de la désinformation et de la mal-information sera-t-elle simplement « réglementée » pour correspondre aux définitions gouvernementales de la « vérité »….… « pour notre propre bien » ?

yogaesoteric

10 mai 2024