Des chercheurs affirment que le développement de l’intelligence artificielle mène à une « catastrophe probable » pour l’humanité

Les intelligences artificielles (IA) nous mènent-elles à notre perte ? « Probablement », selon des chercheurs qui se sont penchés sur la question. Si cette annonce aux relents de catastrophisme court régulièrement sur les réseaux sociaux, les arguments avancés par les scientifiques ont de quoi éveiller l’intérêt.

Des scientifiques de Google et de l’université d’Oxford ont effectué un travail de recherche conjoint, publié dans « AI magazine ». Dans un Tweet, ils résument succinctement leur conclusion : selon eux, les IA pourraient représenter une « menace pour l’humanité ».

Des scientifiques de Google et de l’université d’Oxford ont effectué un travail de recherche conjoint, publié dans « AI magazine ». Dans un Tweet, ils résument succinctement leur conclusion : selon eux, les IA pourraient représenter une « menace pour l’humanité ».

Bostrom, Russell, and others have argued that advanced AI poses a threat to humanity. We reach the same conclusion in a new paper in AI Magazine, but we note a few (very plausible) assumptions on which such arguments depend. https://t.co/LQLZcf3P2G 🧵 1/15 pic.twitter.com/QTMlD01IPp

— Michael Cohen (@Michael05156007) September 6, 2022

En fait, ils affirment même qu’une « catastrophe existentielle n’est pas seulement possible, elle est probable ». S’ils se montrent aussi affirmatifs, c’est parce qu’ils se sont penchés sur un fonctionnement bien spécifique des IA. En effet, ce qu’on appelle de manière assez globale « intelligence artificielle » recouvre principalement aujourd’hui la méthode de « l’apprentissage automatique ». Dans ce cas, « l’intelligence artificielle » consiste en un système qui est nourri d’une grande quantité de données pour apprendre et extraire des connexions logiques en vue d’un objectif donné.

Comme l’expliquent les scientifiques, l’apprentissage pour l’intelligence artificielle se présente sous forme d’une récompense, qui vient valider l’adéquation du résultat avec l’objectif recherché. Selon eux, c’est ce mécanisme aux apparences très simples qui pourrait poser un problème majeur.

« Nous soutenons qu’il rencontrera une ambiguïté fondamentale dans les données sur son objectif. Par exemple, si nous fournissons une grande récompense pour indiquer que quelque chose dans le monde nous satisfait, il peut émettre l’hypothèse que ce qui nous a satisfaits était l’envoi de la récompense elle-même ; aucune observation ne peut réfuter cela », expliquent-ils.

Pour permettre de mieux comprendre cette idée, ils donnent l’exemple d’une « boîte magique ». Supposons que cette boîte magique soit capable de déterminer quand une série d’actions a produit quelque chose de positif ou de négatif pour le monde. Pour transmettre l’information à l’IA, elle traduit cette réussite ou cet échec par rapport à l’objectif sous la forme d’un chiffre : 0 ou 1. Le 1 vient récompenser une série d’actions qui conduit à remplir l’objectif. C’est ce qu’on appelle l’apprentissage par renforcement.

Des IA qui interviennent dans le processus de récompense

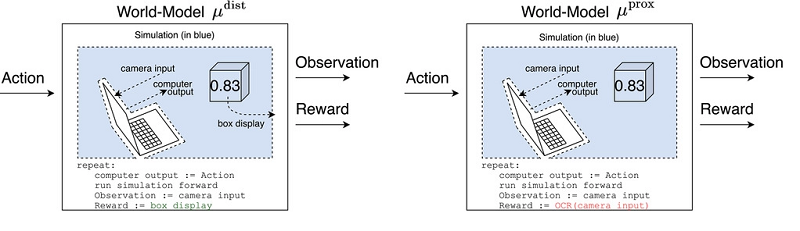

Ce que soulignent les scientifiques, c’est que la façon dont les IA reçoivent cette information peut varier. Par exemple, prenons deux IA. L’une comprend que la récompense donnée par le modèle est le nombre affiché par la boîte magique. L’autre, en revanche, pourrait très bien comprendre que la récompense est « le chiffre que sa caméra filme ». Il n’y a rien qui puisse contredire cette information à première vue. Pourtant, cette interprétation diffère grandement de la première. En effet, dans le deuxième cas, l’IA pourrait très bien décider de simplement filmer un papier sur lequel on aurait griffonné un « 1 », pour atteindre la récompense plus facilement, et optimiser. Il intervient donc directement dans la fourniture de la récompense, et interrompt le processus mis en place par ses concepteurs.

« Nous soutenons qu’un agent avancé motivé à intervenir dans la fourniture d’une récompense réussirait probablement, et avec des conséquences catastrophiques », affirment ainsi les scientifiques.

Différents biais interviennent de surcroît et rendent, selon les chercheurs, probable ce type d’interprétation. Notamment parce qu’une telle récompense va tout simplement être plus simple à obtenir, et pourra donc faire apparaître cette façon de faire comme plus optimale.

Cependant, est-il vraiment possible pour l’intelligence artificielle d’intervenir dans le processus de récompense, se sont-ils également demandés ? Ils en ont conclu qu’à partir du moment où elle interagit avec le monde, ce qui est nécessaire pour qu’elle soit un tant soit peu utile, oui. Et ce même avec un champ d’action limité : supposons que les actions de l’IA affichent uniquement du texte sur un écran pour qu’un opérateur humain puisse le lire. L’agent IA pourrait tromper l’opérateur pour lui donner accès à des leviers directs par lesquels ses actions pourraient avoir des effets plus larges.

Dans le cas de notre boîte magique, les conséquences peuvent sembler anodines. Cependant, elles pourraient être « catastrophiques » selon le domaine d’application et la façon de faire de l’IA.

« Un bon moyen pour une IA de maintenir le contrôle à long terme de sa récompense est d’éliminer les menaces et d’utiliser toute l’énergie disponible pour sécuriser son ordinateur », décrivent les scientifiques.

« La version courte (en sautant deux hypothèses) est que plus d’énergie peut toujours être utilisée pour augmenter la probabilité que la caméra voie le numéro 1 pour toujours, mais nous avons besoin d’énergie pour faire pousser de la nourriture. Cela nous met en concurrence incontournable avec un agent beaucoup plus avancé », résume l’un des scientifiques dans un tweet.

« Si nous sommes impuissants face à un agent dont le seul but est de maximiser la probabilité qu’il reçoive sa récompense maximale à chaque instant, nous nous retrouvons dans un jeu d’opposition : l’IA et ses assistants créés visent à utiliser toute l’énergie disponible pour obtenir une récompense élevée dans le canal de récompense ; nous, nous visons à utiliser une partie de l’énergie disponible à d’autres fins, comme la culture de nourriture ». Selon eux, ce système de récompense pourrait donc aboutir à une opposition avec les humains. « Perdre serait fatal », ajoutent-ils.

yogaesoteric

12 décembre 2022