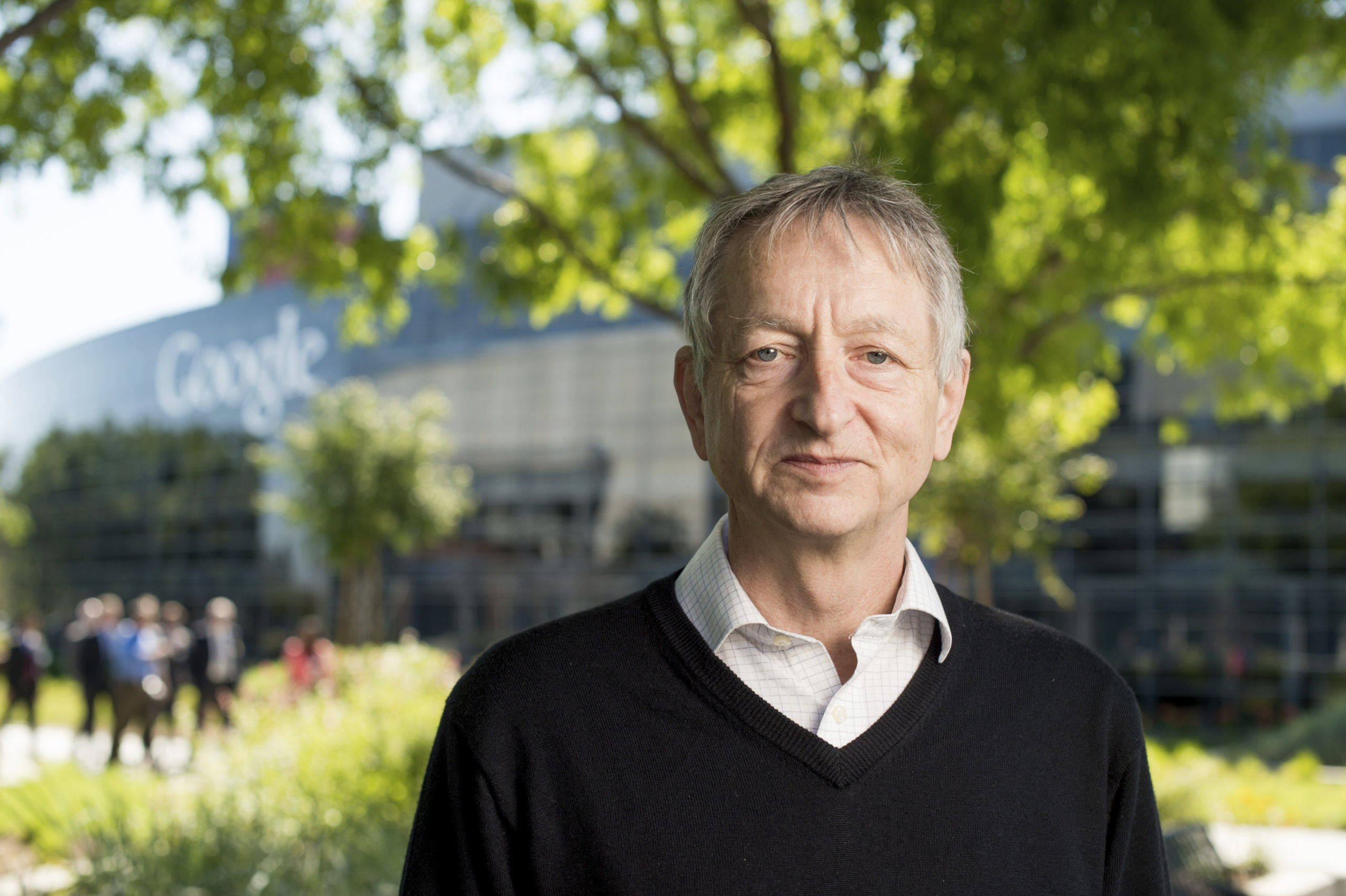

„Nașul Inteligenței Artificiale”, Geoffrey Hinton, părăsește Google și avertizează asupra pericolelor din spatele tehnologiei care imită inteligența umană

Va ajunge pe mâini rele!

„Nașul inteligenței artificiale” părăsește Google și avertizează asupra pericolelor care ne așteaptă. Timp de o jumătate de secol, Geoffrey Hinton a pus bazele tehnologiei care se află la baza roboților de chat precum ChatGPT. Acum, el se teme că aceasta va provoca daune grave, relatează New York Times.

Geoffrey Hinton a fost un pionier al inteligenței artificiale. În 2012, dr. Hinton și doi dintre studenții săi absolvenți de la Universitatea din Toronto au creat o tehnologie care a devenit baza intelectuală pentru sistemele de inteligență artificială pe care cele mai mari companii din industria tehnologică le consideră cheia viitorului lor.

Recent, însă, el s-a alăturat oficial criticilor care spun că aceste companii se îndreaptă cu viteză spre pericol prin campania lor agresivă de a crea produse bazate pe inteligența artificială generativă, tehnologia care alimentează chat bot-uri populare precum ChatGPT.

Dr. Hinton a declarat că a renunțat la slujba sa de la Google, unde a lucrat mai mult de un deceniu și a devenit una dintre cele mai respectate voci din domeniu, pentru a putea vorbi liber despre riscurile inteligenței artificiale. O parte din el, a spus el, regretă acum munca sa de o viață.

„Mă consolez cu scuza obișnuită: dacă nu aș fi făcut-o eu, altcineva ar fi făcut-o”, a declarat dr. Hinton în timpul unui interviu lung, la sfârșitul lunii aprilie, în sufrageria casei sale din Toronto, la mică distanță de locul unde el și studenții săi au făcut descoperirea.

Călătoria doctorului Hinton de la pionier al inteligenței artificiale la cel care avertizează asupra acestei catastrofe marchează un moment remarcabil pentru industria tehnologică, poate cel mai important punct de inflexiune din ultimele decenii. Liderii industriei consideră că noile sisteme de inteligență artificială ar putea fi la fel de importante ca introducerea browserului web la începutul anilor 1990 și ar putea duce la descoperiri în domenii care variază de la cercetarea în domeniul medicamentelor la educație.

Dar pe mulți dintre cei din industrie îi macină teama că lansează ceva periculos în natură. Inteligența artificială generativă poate fi deja un instrument de dezinformare. În curând, ar putea reprezenta un risc pentru locurile de muncă. La un moment dat, spun cei care se tem cel mai mult de tehnologie, ar putea fi un risc pentru umanitate.

„Este greu de văzut cum poți împiedica actorii răi să o folosească pentru scopuri rele”, a declarat dr. Hinton.

După ce start-up-ul OpenAI din San Francisco a lansat o nouă versiune a ChatGPT în martie, peste 1.000 de lideri și cercetători din domeniul tehnologiei au semnat o scrisoare deschisă prin care au cerut un moratoriu de șase luni asupra dezvoltării de noi sisteme, deoarece tehnologiile de inteligență artificială prezintă „riscuri profunde pentru societate și umanitate”.

Câteva zile mai târziu, 19 actuali și foști lideri ai Asociației pentru Progresul Inteligenței Artificiale, o societate academică cu o vechime de 40 de ani, au publicat propria scrisoare de avertizare cu privire la riscurile Inteligenței Artificiale. Din acest grup făcea parte Eric Horvitz, director științific la Microsoft, care a implementat tehnologia OpenAI într-o gamă largă de produse, inclusiv în motorul de căutare Bing.

Dr. Hinton, numit adesea „nașul inteligenței artificiale”, nu a semnat niciuna dintre aceste scrisori și a declarat că nu a dorit să critice public Google sau alte companii până când nu își va părăsi locul de muncă. În luna aprilie, el a anunțat compania că demisionează, iar apoi a vorbit la telefon cu Sundar Pichai, directorul executiv al companiei mamă a Google, Alphabet. El a refuzat să discute în mod public detaliile conversației sale cu domnul Pichai.

Șeful departamentului de știință al Google, Jeff Dean, a afirmat într-o declarație: „Rămânem dedicați unei abordări responsabile față de inteligența artificială. Învățăm continuu pentru a înțelege riscurile emergente, în timp ce inovăm cu îndrăzneală.”

Dr. Hinton, un expatriat britanic în vârstă de 75 de ani, este un academician de o viață, a cărui carieră a fost determinată de convingerile sale personale cu privire la dezvoltarea și utilizarea inteligenței artificiale. În 1972, în calitate de student absolvent la Universitatea din Edinburgh, dr. Hinton a îmbrățișat o idee numită rețea neuronală. O rețea neuronală este un sistem matematic care învață abilități prin analizarea datelor. La acea vreme, puțini cercetători credeau în această idee. Dar aceasta a devenit munca vieții sale.

În anii 1980, dr. Hinton a fost profesor de informatică la Universitatea Carnegie Mellon, dar a părăsit universitatea pentru Canada, deoarece a declarat că a fost reticent în a accepta finanțarea Pentagonului. La acea vreme, cea mai mare parte a cercetării în domeniul inteligenței artificiale din Statele Unite era finanțată de Departamentul Apărării. Dr. Hinton se opune profund utilizării inteligenței artificiale pe câmpul de luptă – ceea ce el numește „soldați roboți”.

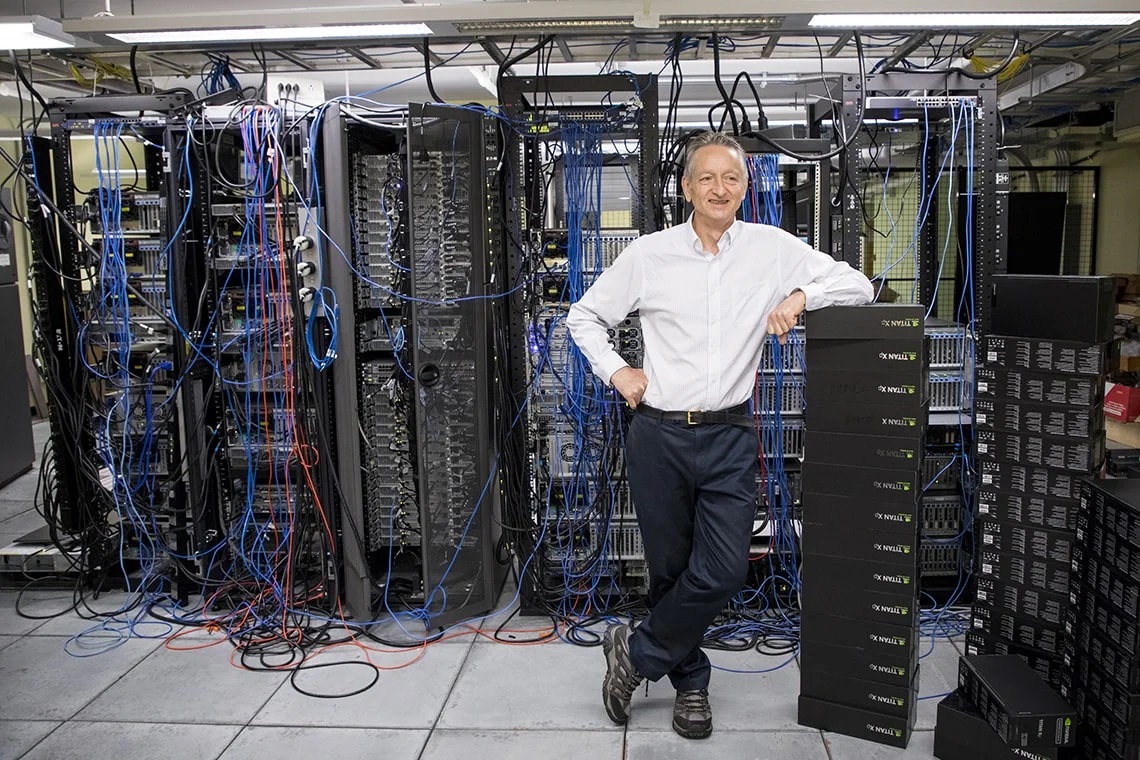

În 2012, dr. Hinton și doi dintre studenții săi din Toronto, Ilya Sutskever și Alex Krishevsky, au construit o rețea neuronală care poate analiza mii de fotografii și se poate învăța singură să identifice obiecte comune, cum ar fi flori, câini și mașini.

Google a cheltuit 44 de milioane de dolari pentru a achiziționa o companie înființată de dr. Hinton și de cei doi studenți ai săi. Iar sistemul lor a dus la crearea unor tehnologii din ce în ce mai puternice, inclusiv a unor noi roboți de chat, precum ChatGPT și Google Bard. Domnul Sutskever a continuat să devină cercetător șef la OpenAI. În 2018, dr. Hinton și alți doi colaboratori de lungă durată au primit Premiul Turing, adesea numit „Premiul Nobel al informaticii”, pentru activitatea lor în domeniul rețelelor neuronale.

Cam în aceeași perioadă, Google, OpenAI și alte companii au început să construiască rețele neuronale care să învețe din cantități uriașe de text digital. Dr. Hinton a considerat că era o modalitate puternică pentru ca mașinile să înțeleagă și să genereze limbaj, dar era inferioară modului în care oamenii gestionau limbajul.

Apoi, anul trecut, pe măsură ce Google și OpenAI au construit sisteme care foloseau cantități mult mai mari de date, opinia sa s-a modificat. El credea în continuare că sistemele erau inferioare creierului uman în unele privințe, dar credea că eclipsau inteligența umană în altele. „Poate că ceea ce se petrece în aceste sisteme”, a spus el, „este de fapt mult mai bun decât ceea ce se petrece în creier”.

Pe măsură ce companiile își îmbunătățesc sistemele de inteligență artificială, crede el, acestea devin din ce în ce mai periculoase. „Uitați-vă cum era acum cinci ani și cum este acum”, a spus el despre tehnologia IA. „Luați diferența și propagați-o înainte. Asta este înfricoșător.”

Până anul trecut, a spus el, Google a acționat ca un „administrator adecvat” pentru această tehnologie, atent să nu lanseze ceva care ar putea provoca daune. Dar acum că Microsoft și-a îmbogățit motorul de căutare Bing cu un chatbot – provocând activitatea principală a Google – Google se grăbește să implementeze același tip de tehnologie. Giganții tehnologiei sunt blocați într-o competiție care ar putea fi imposibil de oprit, a declarat dr. Hinton.

Preocuparea sa imediată este că internetul va fi inundat de fotografii, videoclipuri și texte false, iar persoana obișnuită „nu va mai fi capabilă să știe ce este adevărat”.

De asemenea, el este îngrijorat că tehnologiile de inteligență artificială vor bulversa în timp piața muncii. În prezent, roboții de chat, precum ChatGPT, tind să completeze lucrătorii umani, dar ar putea înlocui asistenții juridici, asistenții personali, traducătorii și alte persoane care se ocupă de sarcini repetitive. „Elimină munca de rutină”, a spus el. „Ar putea elimina mai mult decât atât.”

Pe viitor, el este îngrijorat că viitoarele versiuni ale tehnologiei reprezintă o amenințare pentru umanitate, deoarece acestea învață adesea comportamente neașteptate din cantitățile uriașe de date pe care le analizează. Acest fapt devine o problemă, a spus el, pe măsură ce oamenii și companiile permit sistemelor de inteligență artificială nu numai să genereze propriul cod informatic, ci și să ruleze efectiv acest cod pe cont propriu. Și se teme de o zi în care armele cu adevărat autonome – acei roboți ucigași – vor deveni realitate.

„Ideea că aceste mașinării ar putea deveni mai inteligente decât oamenii – câțiva oameni au crezut asta”, a spus el. „Dar cei mai mulți oameni au crezut că era departe de adevăr. Și eu am crezut că era foarte departe de adevăr. Am crezut că era la o distanță de 30-50 de ani sau chiar mai mult. Evident, nu mai cred asta.”

Mulți alți experți, inclusiv mulți dintre studenții și colegii săi, spun că această amenințare este ipotetică. Dar dr. Hinton crede că această cursă dintre Google și Microsoft și alții va escalada într-o cursă globală care nu se va opri fără un fel de reglementare globală.

Dar aceasta ar putea fi imposibilă, a spus el. Spre deosebire de armele nucleare, nu există nicio modalitate de a ști dacă companiile sau țările lucrează în secret la această tehnologie. Cea mai bună speranță este ca cei mai importanți oameni de știință din lume să colaboreze pentru a găsi modalități pentru a controla tehnologia.

„Nu cred că ar fi indicat să extindă mai mult această tehnologie până nu vor înțelege dacă o pot controla”, a spus el.

Dr. Hinton a spus că atunci când oamenii obișnuiau să-l întrebe cum a putut lucra la o tehnologie care era potențial periculoasă, el îl parafraza pe Robert Oppenheimer, care a condus efortul SUA de a construi bomba atomică: „Atunci când vezi ceva care este plăcut din punct de vedere tehnic, mergi mai departe și o faci”.

Citiți și:

Inteligența Artificială: O privire seculară asupra Antihristului digital

Spaima unui fost director Google: Dezvoltatorii de inteligență artificială creează un zeu

Elon Musk avertizează că inteligența artificială ar putea provoca „distrugerea civilizației”: Odată ce AI „va deține controlul”, ar putea fi prea târziu pentru a stabili reglementări

yogaesoteric

13 iunie 2023