Inteligența artificială și armele biologice

Inteligența artificială prezintă noi riscuri în dezvoltarea armelor biologice

- Progresele din domeniul științei și al inteligenței artificiale facilitează crearea de viruși periculoși, ceea ce ridică probleme de biosecuritate.

- O echipă mică a sintetizat recent un virus de la zero, evidențiind accesibilitatea acestei tehnologii.

- Instituții consacrate, precum Australia Group, joacă un rol crucial în prevenirea utilizării abuzive a IA și a biotehnologiei în scopuri dăunătoare.

În ultimii ani, lumea a fost martora unor progrese fără precedent în domeniul chimiei, al biologiei sintetice și al inteligenței artificiale (IA). Aceste inovații, atunci când sunt combinate, au inaugurat o nouă eră a posibilităților științifice. Cu toate acestea, odată cu o mare putere vine și o mare responsabilitate, iar o preocupare emergentă este potențiala utilizare abuzivă a acestei convergențe de cunoștințe. Sinteza virușilor, altădată o sarcină rezervată experților foarte specializați, devine din ce în ce mai accesibilă, ceea ce ridică îngrijorări cu privire la crearea de agenți patogeni letali.

Un remarcabil punct de cotitură

Un important punct de cotitură în acest domeniu a avut loc atunci când o mică echipă de cercetători s-a angajat în sinteza unei noi variante a virusului variolei cabaline, un orthopoxvirus. Deși mai puțin patogen decât variola, acest virus a devenit un simbol al îngrijorării datorită ușurinței cu care a fost creat. Echipa a obținut fragmente de ADN de la un focar de variolă din Mongolia din 1976 și a construit fragmentele de ADN cu ajutorul unei companii de sinteză de ADN.

Acest demers a marcat un „Rubicon în domeniul biosecurității”, demonstrând că un ortopoxvirus poate fi creat de la zero folosind materiale și informații disponibile comercial, la un preț de aproximativ 100.000 de dolari.

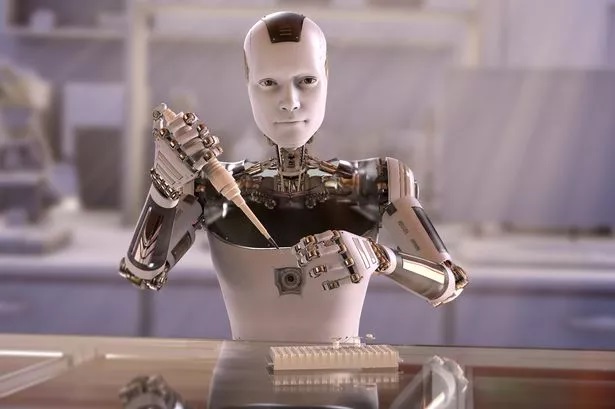

Rolul inteligenței artificiale

Pe măsură ce tehnologia continuă să evolueze, rolul inteligenței artificiale în acest peisaj nu poate fi ignorat. Modelele lingvistice mari (LLM), precum cele care au devenit accesibile publicului de la sfârșitul anului 2022, au potențialul de a ajuta la construirea de arme chimice sau biologice. În timp ce discuțiile despre IA s-au axat adesea pe dezvoltarea de sisteme superinteligente, o preocupare mai imediată este contribuția LLM-urilor actuale la reducerea „barierelor informaționale” în crearea de agenți patogeni ucigași.

Atunci când sunt înarmate cu cunoștințele corecte în domeniul biologiei sintetice, aceste modele ar putea ajuta persoanele cu o pregătire minimă să depășească provocările legate de producerea unui agent patogen viabil cu potențial pandemic.

Accesibilitatea la LLM-uri

Un aspect izbitor al acestei preocupări este accesibilitatea la LLM-uri. Crearea agenților patogeni sintetici devine din ce în ce mai fezabilă cu doar un sintetizator de genom întreg de desktop PC, acces la literatura specifică și o anumită pregătire științifică. Costul unui astfel de demers a scăzut dramatic, estimările sugerând că în curând ar putea necesita ceva cu puțin peste 20.000 de dolari. Această accesibilitate ridică întrebări cu privire la modul de reglementare și monitorizare a utilizării tehnologiei IA în acest context.

Abordarea riscurilor

Este esențial de remarcat faptul că dezvoltarea unui agent patogen sintetic nu garantează apariția unei pandemii. Cu toate acestea, riscurile potențiale sunt de netăgăduit. Pentru a gestiona aceste riscuri, experții sugerează să se apeleze la instituții consacrate care joacă deja un rol esențial în controlul armelor biologice și chimice.

Rolul grupului din Australia

O astfel de instituție este Australia Group (AG – Grupul Australia), fondat în 1984, în timpul războiului dintre Iran și Irak. Axat inițial pe controlul precursorilor chimici pentru arme neconvenționale, AG a evoluat pentru a armoniza reglementarea componentelor „chimico-bio”. În fața noii ere a inteligenței artificiale și a progreselor în domeniul biologiei sintetice, AG ar putea servi drept platformă de cooperare internațională pentru a aborda aceste amenințări emergente. Prin elaborarea unor liste de control comune cuprinzătoare și prin coordonarea eforturilor de prevenire a utilizării abuzive a tehnologiei, AG poate juca un rol esențial în contracararea pericolelor potențiale reprezentate de convergența dintre IA și biotehnologie.

Concluzie

În timp ce omenirea se confruntă cu provocările actuale ale unei pandemii globale și ale altor crize, apariția unor noi amenințări în domeniul armelor biologice ne reamintește de necesitatea unor măsuri proactive. Progresul rapid al tehnologiei, împreună cu accesibilitatea inteligenței artificiale și a biologiei sintetice, necesită un răspuns internațional coordonat. Grupul Australia reprezintă un far de speranță, oferind o platformă pentru a naviga prin aceste provocări și a proteja securitatea globală.

În absența unor măsuri proactive, riscurile utilizării abuzive a IA și a biotehnologiei sunt mari, iar lumea este necesar să se unească pentru a preveni consecințele potențial catastrofale care ar putea rezulta din crearea și desfășurarea agenților patogeni sintetici. Este momentul să acționăm înainte ca lumea să se confrunte cu o nouă și neprevăzută amenințare la adresa stabilității și securității globale.

Citiți și:

Viruși, epidemii și experimente. Istoria războiului biologic

Studiu: Inteligența artificială poate crea, în numai 6 ore, 40.000 de arme chimice!

Inteligența artificială acaparează domeniul armelor nucleare

yogaesoteric

31 octombrie 2023